El viejo «cuento del tío» se ha sofisticado gracias a la inteligencia artificial: los algoritmos consiguen recrear la voz de otra persona y así los delincuentes cometen nuevas estafas. Ante esto, expertos en ciberseguridad entregan sus recomendaciones y advertencias.

Una noticia hizo eco en el mundo la semana pasada y dio cuenta de los rápidos alcances que ha tenido la inteligencia artificial (IA). Ocurrió en Arizona, Estados Unidos, donde una familia reportó a la policía por haber recibido una llamada de su hija, dándoles aviso de que, supuestamente, había sido secuestrada. Tras el anuncio, el secuestrador tomó el teléfono y pidió un millón de dólares por su rescate. Tras las amenazas que hizo el hombre de dañarla en caso de no recibir el dinero, se escuchaban los gritos y sollozos de la mujer.

Si no hubiera sido porque la madre logró comunicarse con su hija desde otra línea, la familia habría pagado por el rescate. La policía explicó a la prensa que ellos estaban convencidos de que el secuestro era real. No había forma de sospechar que no era la hija, pues su voz, explicaron las fuentes del caso, era exactamente la misma. Pero quien la emitió no fue una persona, sino una inteligencia artificial. La voz había sido clonada.

Ciberdelitos al alza

Los ciberdelitos han aumentado exponencialmente en el mundo, especialmente a partir de la pandemia. Mientras en España se habla de un 72% de incremento, en Chile estos se habrían cuadruplicado. “Tan sólo en la semana del 6 marzo de este año se registraron 1.100 ataques y más de 4.200 en la semana del 20 de marzo”, expone Alex Aguilar, subgerente de TI, Calidad y Seguridad de Adexus.

Entre las técnicas más utilizadas para llevar adelante estos crímenes aparecen el ransomware, el malware y el phishing, las que en su conjunto se conocen como “ingeniería social”: se basan en el engaño a la víctimas para obtener información confidencial y, de esa manera, conseguir su objetivo, el que usualmente es dinero.

Estas prácticas se han registrado por más de una década, sin embargo, la reciente aparición de la inteligencia artificial ha permitido que el cibercrimen perfeccione sus técnicas y haga más compleja su prevención y detección. “Las bases de la IA son el entrenamiento automático y profundo, basados en el machine learning, lo cual permite la generación de ataques más sofisticados, dirigidos y con mayor capacidad destructiva”, apunta Aguilar.

Juan Alejandro Aguirre, Senior Manager Sales Engineering para Latinoamércia de Sophos, empresa global de ciberseguridad, explica que en el caso de Arizona, por ejemplo, el intento de extorsión que sufrió la familia se basó en un método conocido como vishing, donde se suplanta la identidad con el fin de obtener datos bancarios, contraseñas y, en esta ocasión, directamente dinero.

Lo peculiar de dicho caso es que el vishing estuvo potenciado por el uso de inteligencia artificial, a través de la cual los ciberdelincuentes clonaron la voz de la supuesta víctima de secuestro para llevar adelante el fraude.

¿Puede algo así ocurrir en Chile?

“Por supuesto”, responde Aguirre. Alex Aguilar concuerda y asegura que es cosa de tiempo para que este tipo de ciberdelitos llegue al país. “Hoy se encuentran presentes amenazas de suplantación, pero todavía no incluyen inteligencia artificial, la que claramente van a sofisticar este tipo de ciberataques”, argumenta.

Cómo es posible que eso ocurra, se preguntará usted. Tomás Vera, director de innovación de Zenta Group, explica que las tecnologías de clonación de voz están “a disposición de cualquier persona, de forma paga y gratuita”. Si bien hoy existen ciertas complejidades para que se materialicen en nuestro territorio —como que aún están preprogramadas para operar en inglés—, es muy posible que en el corto plazo las herramientas se adecuen para “reproducir textos en español”.

Sólo tres segundos de muestra

¿Cómo puede la inteligencia artificial clonar la voz de alguien? De acuerdo a Juan Alejandro Aguirre, su funcionamiento se basa en la recopilación de audio de la persona que desea suplantar. “Estos datos alimentan a una red neuronal (un modelo específico de IA) para recrear la voz de la persona”. Una vez que el sistema ha sido entrenado, puede generar un nuevo audio que “suena idéntico a la persona, incluso con palabras que no dijo o tonos que no usó en las grabaciones que alimentaron el sistema”.

Estos sistemas incorporan modelos de texto a voz. Es decir, replican lo que uno como usuario les ordena que digan por medio de un texto. Previamente, un algoritmo escucha la voz a clonar y extrae los parámetros que configuran un sintetizador de voz humano. “Por eso es tan rápido y certero”, acota Tomás Vera.

“Las tecnologías actuales permiten una capacidad de procesamiento suficiente como para la ejecución de rutinas basadas en IA que permiten la suplantación de voz e inclusive de rostro”, sostiene Alex Aguilar. Un ejemplo concreto de ello, agrega, “es lo que se ve en la industria del cine”.

Los fanáticos —y los no tanto— de Star Wars recordarán haber visto en acción a Carrie Fisher como una rejuvenecida Princesa Leia en la cinta Rogue One de 2016. Fisher, sin embargo, falleció antes de que pudiera rodar su escena. ¿Cómo pudo aparecer en la película? Simple: gracias a una doble y a la tecnología que permitió incorporar los rasgos de Fisher en su rostro.

En la música se han visto casos similares de artistas vivos y muertos que son suplantados para crear canciones e, incluso, álbumes completos que ellos nunca hicieron ni tampoco autorizaron para llevar sus nombres. Sin embargo, algunos medios lo celebran como una verdadera gracia.

Lo que asusta realmente es la poca data que necesitan estos sistemas inteligentes para clonar una voz. Algunos expertos estadounidenses, al comentar el caso ocurrido en Arizona, sostuvieron que con sólo tres segundos de voz de una persona se puede conseguir una réplica muy similar. Aunque Aguirre confirma que una clonación así puede parecer convincente, “se necesitan de muestras más extensas y diversas del mismo individuo para poder imitar características más complejas, como la inflexión en emociones”.

Para clonar las características más peculiares de la voz y la forma de hablar de una persona, Tomás Vera asegura que se necesitan al menos de 28 segundos de grabación. “Aunque todo depende de la calidad de la muestra de voz” con la que cuentan los ciberdelincuentes. Es decir, “cuánto ruido ambiente hay en el audio, que palabras o dígitos pronunció la persona, en qué tono los dijo, etcétera”.

Algunos consejos para prevenir

Dicho todo esto, ¿cómo se supone que uno se puede proteger ante estos eventuales ataques? ¿Es posible tomar suficientes precauciones para evitar el robo de una información tan sensible como la voz? Parece bastante complejo cuando la misma tecnología promueve el uso de datos biométricos —en la que se analizan características físicas y de comportamiento de cada persona— para autenticar la identidad cada vez que se quiere desbloquear el smartphone, el notebook, ingresar a una cuenta de correo o de redes sociales, entre otras acciones.

Alex Aguilar dice que si bien el método de autenticación multifactor es recomendado, “la población centraliza esto en un sólo contenedor que generalmente es el smartphone, convirtiéndose en el mayor punto de riesgos y amenazas”.

A este dispositivo es al que suelen llegar mensajes de texto, correos o tokens generados por aplicaciones de casas comerciales. Por lo tanto, si este punto único es vulnerado, los ciberdelincuentes tendrán acceso a todos los mecanismos de autenticación. Por eso, agrega Aguilar, “se hace imprescindible culturizar a la ciudadanía para la utilización de manera distribuida” de los mecanismos de autenticación.

Por otro lado, olvidarse de la tecnología y volver a un mundo análogo parece imposible. Por lo demás, si ya alguna vez ingresaste un dato personal en algún servicio digital, este ya reside en el universo web. En ese sentido, tus datos de voz pueden estar desde en un mensaje de audio que enviaste en alguna aplicación de mensajería o redes sociales, hasta en videos y grabaciones compartidas en plataformas como YouTube o TikTok, entre otras. Así que vamos a lo más realista:

¿Cómo prevenir el vishing y que tu voz sea clonada?

1- Mantén tu información personal segura

Evita compartir información personal sensible en línea, como grabaciones de voz, contraseñas u otra información que pueda ser utilizada para clonar tu voz.

2- Ten precaución con las grabaciones de voz

No grabes tu voz en llamadas o mensajes de voz no confiables, y evita proporcionar información confidencial a través de grabaciones de voz en plataformas o aplicaciones no verificadas, como las encuestas telemáticas de instituciones o empresas que no conozcas.

3- Mantén tus dispositivos seguros

Actualizar los dispositivos y aplicaciones a sus últimas versiones de software es el método más efectivo para ello. Además, utiliza programas antivirus confiables para proteger tus dispositivos de posibles amenazas.

4- Utiliza contraseñas fuertes, evitando que accedan a tus dispositivos

Evita contraseñas obvias, como también repetirlas en diversas aplicaciones. El uso de combinaciones de letras —mayúsculas y minúsculas—, números y signos da mayor grado de seguridad.

5- Leer a conciencia términos y condiciones de las diversas aplicaciones que se utilizan

“La recomendación más importante que se puede dar es ser muy cuidadoso con el uso de información biométrica (rostro, voz) en redes sociales, y sospechar y leer los términos y condiciones de aplicaciones de filtros de rostro y voz tan populares en la actualidad”, dice Juan Alejandro Aguirre.

¿Es posible discernir entre una voz humana y una clonación de IA?

“Es algo bastante subjetivo, pero los seres humanos tienen en muchas ocasiones la capacidad de detectar cuándo la IA está suplantando rostros o voces”, dice Aguirre. Algunas claves son:

- Las emociones: Cuando se conoce a una persona, es posible identificar tonos e inflexiones que no corresponden a sus emociones.

- Palabras: Cuando las muestras no son tan grandes, es posible que el discurso del ciberdelincuente no corresponda con la forma de hablar de la persona suplantada.

- Grabaciones: Muchas veces las estafas de vishing que utilizan IA recurren a grabaciones solicitando ayuda de la persona suplantada y, luego, habla otra que puede actuar como secuestrador. En este caso, el secuestrador se niega a que el “secuestrado” pueda entablar una conversación.

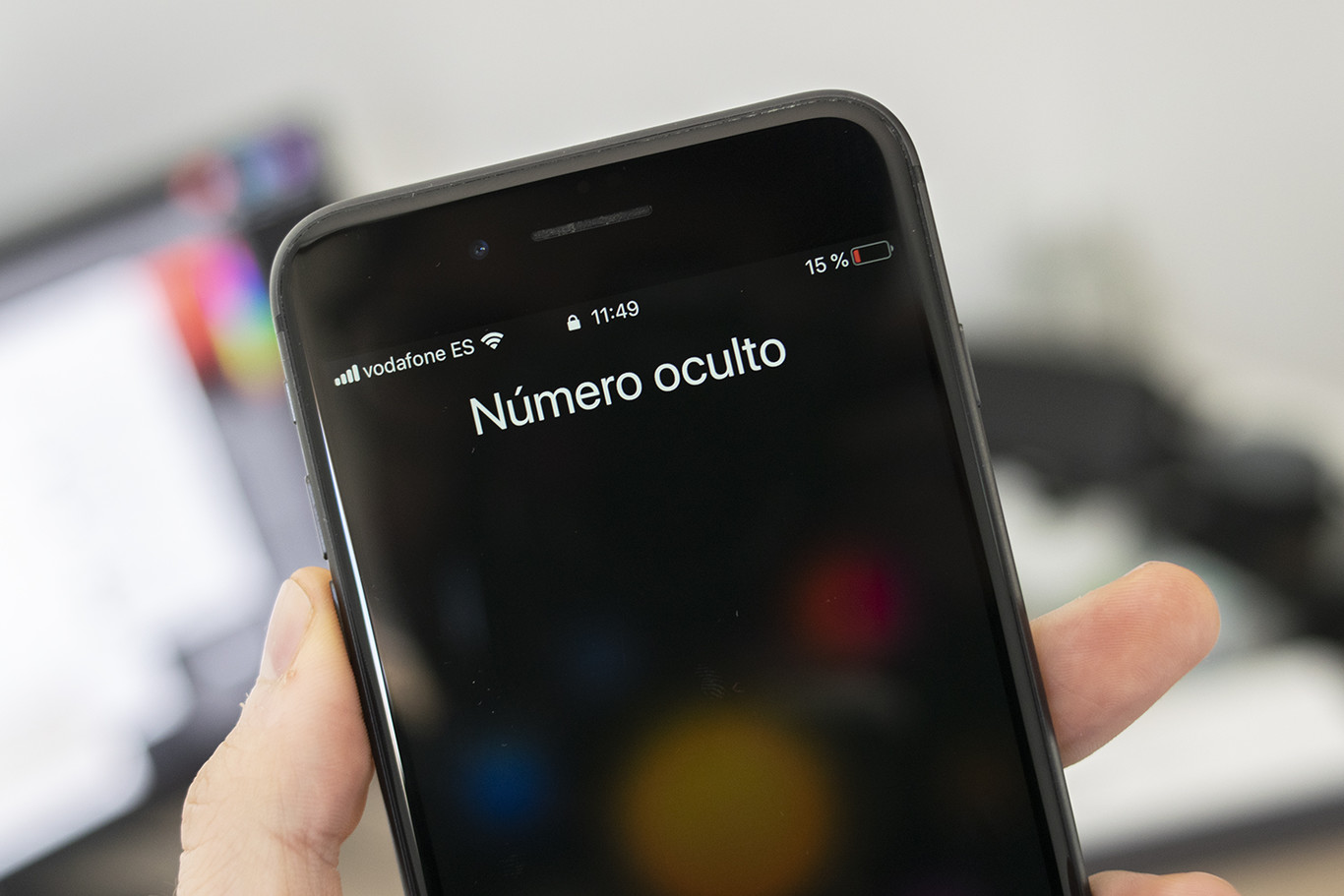

- Números desconocidos, ocultos o de otros países: Siempre es sospechoso el contacto de personas conocidas a través de números desconocidos.

- Doble verificación: Muchas veces, la forma más simple de identificar estas estafas o fraudes es intentar comunicarse directamente con la persona suplantada y confirmar que no es ella quien está solicitando ayuda, dinero o información.

Por otro lado, ante este contexto tecnológico, que a estas alturas parece omnipresente y hegemónico, los expertos recomiendan manejar ciertos códigos a nivel familiar u otros grupos de interés que en casos de emergencia permitan identificar la veracidad de la identidad. Por ejemplo, el uso de palabras clave y, también, preguntas clave.

“Hay que recordar que la IA se basa en el aprendizaje de acciones y respuestas estándar. Por lo tanto, es necesario utilizar situaciones y contextos con una secuencia Ilógica. Por ejemplo: si es un domingo, se puede preguntar ‘¿cómo te fue en el colegio?’”, enseña Alex Aguilar.

“Es muy complejo evitar que nos clonen nuestra voz, pero sí es posible prepararnos como familia o con amigos a soportar este tipo de ataques o fraudes”, agrega Tomás Vera. En ese sentido, lo recomendable es “definir un protocolo de cómo le hablamos a alguien de confianza, familiares o amigos en caso de necesitar ayuda”.

Concientizar al entorno respecto a este tipo de riesgos, también es aconsejable. “Como lo hemos hecho con el cuento del tío y otros fraudes, preparándose para que hagan preguntas clave que el delincuente no va a estar preparado para contestar y con eso podamos identificar qué se trata de un fraude”, cierra Vera.

Fuente: La Tercera