Las compañías están llegando a extremos, como reducir sus ganancias, retrasar los lanzamientos o mendigar a los amigos, para arreglárselas con la falta de GPU, los procesadores que están en el corazón de los programas de IA generativa.

Durante los días laborales, alrededor de las 11 de la mañana, hora del Este, Europa se prepara para concluir la jornada; entonces la costa este de Estados Unidos llega al mediodía y la actividad en Silicon Valley remonta. El generador de imágenes impulsado por inteligencia artificial (IA) de la startup Astria, con sede en Tel Aviv (Israel), está tan atareado como siempre. Sin embargo, la compañía no saca mucho provecho de este período de actividad intensa.

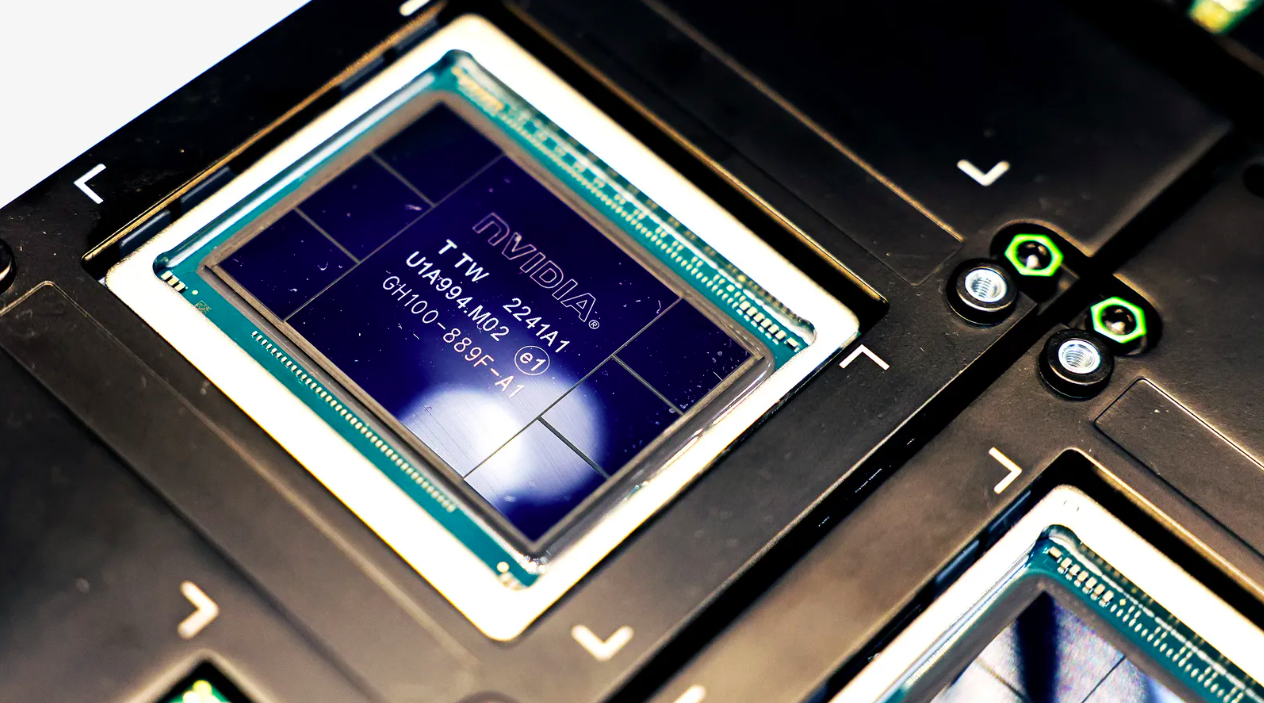

Empresas como Astria, que desarrollan tecnologías de IA, utilizan unidades de procesamiento gráfico (GPU, por sus siglas en inglés) para entrenar software que aprende patrones de fotografías y otros materiales. Los chips también manejan la inferencia, o el aprovechamiento de esas lecciones para generar contenido en respuesta a las instrucciones (prompts) del usuario; en pocas palabras, llevar a la práctica lo aprendido. Pero la prisa mundial por integrar esta tecnología en todas las aplicaciones y programas, combinada con los persistentes problemas de fabricación que se remontan a principios de la pandemia, han hecho que escaseen las GPU, o unidades de proceso de gráficos.

El problema de la falta de GPU para soluciones de IA

Esa escasez de suministro significa que, en las horas de máxima actividad, las GPU ideales del principal proveedor de computación en la nube de Astria, Amazon Web Services (AWS), que la startup necesita cuando genera imágenes para sus clientes, operan a total capacidad, y la compañía tiene que emplear GPU más potentes y más caras para realizar el trabajo. Los costos se multiplican rápidamente. “¿Cuánto más voy a pagar?”, expresa Alon Burg, fundador de Astria, quien bromea sobre si invertir en acciones de Nvidia, el mayor fabricante mundial de las GPU, sería más lucrativo que dedicarse a su startup. Astria cobra a sus clientes de un modo que equilibra esos costosos horarios pico, pero sigue gastando más de lo deseado. “Me encantaría reducir gastos y contratar a unos cuantos ingenieros más”, comparte Burg.

No se prevé un final inmediato para esta falta de GPU. La puntera del mercado, Nvidia, que representa entre el 60 y el 70% de la oferta mundial de chips para servidores de inteligencia artificial, anunció ayer que había vendido la cifra récord de 10,300 millones de dólares en GPU para centros de datos en el segundo trimestre, un 171% más que hace un año, y que las ventas deberían volver a superar las expectativas en el trimestre actual. “Nuestra demanda es tremenda”, declaró Jensen Huang, CEO de la empresa, a los analistas en una conferencia sobre resultados. Se espera que el gasto mundial en chips destinados a la IA alcance los 53,000 millones de dólares este año y se duplique con creces en los próximos cuatro siguientes, según la firma de investigación de mercados Gartner.

La continua escasez hace que las empresas tengan que innovar para mantener el acceso a los recursos que necesitan. Algunas reúnen capital para asegurarse de que no dejarán a los usuarios abandonados. En todas partes, términos de ingeniería como “optimización” y “menor tamaño del modelo” se vuelven tendencia cuando las compañías intentan reducir sus necesidades de GPU, y los inversionistas han apostado este año cientos de millones de dólares en startups cuyo software facilita a las empresas a arreglárselas con las GPU que tienen. Una de ellas, Modular, recibió consultas de más de 30,000 clientes potenciales desde su lanzamiento en mayo, según su cofundador y presidente, Tim Davis. La habilidad para superar la crisis durante el próximo año podría convertirse en un factor determinante de la supervivencia en la economía de la IA generativa.

“Vivimos en un mundo de capacidad limitada en el que tenemos que usar la creatividad para juntar cosas, mezclarlas y equilibrarlas”, comenta Ben Van Roo, CEO de Yurts, una empresa de asistencia a la redacción empresarial basada en IA. “Me niego a gastar mucho dinero en [capacidad de] procesamiento”.

Alternativas a las GPU de Nvidia para IA

Los proveedores de computación en la nube son perfectamente conscientes de que sus clientes tienen problemas de capacidad. El aumento de la demanda “tomó un poco desprevenido al sector”, asegura Chetan Kapoor, director de administración de productos de AWS.

El tiempo necesario para adquirir e instalar nuevas GPU en sus centros de datos ha retrasado a los gigantes de la nube, y las condiciones específicas de mayor demanda también añaden tensión. Mientras que la mayoría de las aplicaciones funcionan mediante procesadores distribuidos por todo el mundo, el entrenamiento de los programas de IA generativa tiende a ser más eficaz cuando las GPU están físicamente agrupadas, a veces con 10,000 chips a la vez. Esto compromete la disponibilidad como nunca antes.

Kapoor explica que el cliente típico de IA generativa de AWS accede a cientos de GPU. “Si hay una petición de un cliente concreto que requiere 1,000 GPU mañana, nos llevará algún tiempo hacerles espacio”, dice Kapoor. “Pero si son flexibles, podemos solucionarlo”.

AWS ha sugerido a los clientes que contraten servicios más caros y personalizados a través de su sistema Bedrock, en la que las necesidades de chips se incorporan a la oferta sin que los clientes tengan que preocuparse. O también que podrían probar los chips de inteligencia artificial exclusivos de AWS, Trainium e Inferentia, que han registrado un repunte indefinido en su incorporación, destaca Kapoor. Tradicionalmente, adaptar los programas para que funcionen con esos chips en lugar de utilizar las opciones de Nvidia ha sido una tarea laboriosa, aunque Kapoor añade que, en algunos casos, para pasar a Trainium basta con cambiar dos líneas de código de software.

Los retos también abundan en otros ámbitos. Google Cloud no ha sido capaz de mantener el ritmo de la demanda de su equivalente de GPU de fabricación propia, conocido como TPU, de acuerdo con un empleado no autorizado a hablar con los medios de comunicación. Un representante de la empresa no respondió a nuestra solicitud de comentarios. En tanto, la unidad en la nube Azure de Microsoft ha ofrecido reembolsos a los clientes que no utilicen las GPU que reservaron, según reportó The Information en abril. Microsoft declinó hacer comentarios.

Las compañías de computación en la nube preferirían que los clientes reservaran capacidad con meses o años de antelación, para que esos proveedores planificaran mejor sus propias compras e instalaciones de GPU. Pero las startups, que por lo general disponen de capital reducido y tienen necesidades intermitentes mientras desarrollan sus productos, se han mostrado reacias a contraer compromisos, prefiriendo los planes de compra sobre la marcha. Esto ha provocado un incremento del negocio para los proveedores alternativos de la nube, como Lambda Labs y CoreWeave, que han obtenido casi 500 millones de dólares de inversionistas este año entre los dos. Astria, la startup generadora de imágenes, está entre sus clientes.

AWS no está precisamente contenta de perder frente a los nuevos operadores del mercado, por lo que está considerando otras opciones. “Estamos pensando en distintas soluciones a corto y largo plazo para ofrecer la experiencia que buscan nuestros clientes”, indica Kapoor, quien no quiere dar más detalles al respecto.

Fila de espera por unidades de procesamiento para IA

Las carencias de los proveedores de servicios en la nube están afectando a sus clientes, entre los que se incluyen algunos grandes nombres de la tecnología. La red social Pinterest está aumentando su uso de la IA para prestar un mejor servicio a usuarios y anunciantes, según Jeremy King, director de tecnología. La compañía está planteándose utilizar los nuevos chips de Amazon. “Necesitamos más GPU, como todos”, reconoce King. “La escasez de chips es algo real”.

OpenAI, que desarrolla ChatGPT y licencia la tecnología subyacente a otras empresas, depende en gran medida de los chips de Azure para proporcionar sus servicios. La escasez de GPU le ha obligado a establecer límites de uso en las herramientas que vende. Eso ha sido lamentable para los clientes, como la empresa que está detrás del asistente de IA Jamie, que resume el audio de las reuniones utilizando la tecnología de OpenAI. Los planes para un lanzamiento público se han retrasado al menos cinco meses, en parte porque querían perfeccionar su sistema, pero también por los límites de uso, declara Louis Morgner, cofundador de la startup. El problema no ha desaparecido. “Solo faltan unas semanas para que [Jamie] se lance al público y entonces tendremos que vigilar de cerca la capacidad de crecimiento de nuestro sistema, dadas las limitaciones de nuestros proveedores de servicios”, dice Morgner.

“El sector está experimentando una fuerte demanda de GPU”, reitera Niko Felix, vocero de OpenAI. “Seguimos trabajando para garantizar que nuestros clientes de la interfaz de programación de aplicaciones tengan la capacidad necesaria para satisfacer sus necesidades”.

En este punto, cualquier conexión que dé a una startup acceso a capacidad de procesamiento es vital. Inversionistas, amigos, vecinos: los directivos de las empresas emergentes recurren a una gran variedad de relaciones para conseguir más potencia para sus IA. Astria, por ejemplo, obtuvo capacidad adicional en AWS con la ayuda de Emad Mostaque, CEO de Stability AI, que es un estrecho colaborador de la plataforma de Amazon y en cuya tecnología tiene base Astria.

La startup de contabilidad, Pilot, que utiliza la tecnología de OpenAI para la clasificación de algunos datos rutinarios, accedió anticipadamente a GPT-4 tras pedir ayuda a amigos de la universidad, empleados e inversionistas de capital de riesgo con conexiones en la empresa. No está claro si esos vínculos aceleraron la salida de Pilot de una lista de espera, pero ahora gasta unos 1,000 dólares al mes en OpenAI, y esas conexiones le serán útiles cuando necesite incrementar su cuota, comenta Waseem Daher, su CEO. “Si no aprovechas esta tecnología de IA generativa, otro lo hará, y es lo suficientemente poderosa como para que no quieras arriesgarte”, resalta Daher. “Quieres ofrecer los mejores resultados a tus clientes y estar al tanto de lo que ocurre en el sector”.

Startups, las más afectadas por la escasez de GPU para IA

Además de luchar por acceder a mayor capacidad, las compañías intentan hacer menos con más. Las empresas que experimentan con la IA generativa se obsesionan actualmente con la “optimización”: hacer posible el procesamiento, con resultados satisfactorios, en las GPU más asequibles. Es similar a ahorrar dinero al deshacerte de un viejo refrigerador devorador de energía que solo almacena unas pocas bebidas por una moderna mininevera que funcione con energía solar la mayor parte del tiempo.

Las empresas intentan escribir mejores indicaciones sobre el modo en que los chips deben procesar las instrucciones de programación, intentando reformatear y limitar la cantidad de datos utilizados para entrenar los sistemas de IA y después reducir el código de inferencia al mínimo necesario para realizar la tarea en cuestión. Eso significa crear sistemas múltiples y más pequeños: tal vez un generador de imágenes que produzca animales y otro que cree de seres humanos, y cambiar de uno a otro en función de las solicitudes del usuario.

También programan los procesos que no son cruciales en términos de tiempos de entrega para que se ejecuten cuando la disponibilidad de la GPU es mayor, y hacen concesiones para equilibrar la velocidad con la asequibilidad.

Resemble AI, una startup de generación de voz, se conforma con tardar una décima de segundo más en procesar una solicitud de un cliente en un chip antiguo si eso significa gastar una décima parte de lo que costarían las opciones de gama más alta, sin una diferencia perceptible en la calidad del audio, señala el CEO Zohaib Ahmed. También está dispuesto a mirar más allá de Lambda y CoreWeave a medida que sus condiciones se vuelvan menos atractivas, animándose a asumir compromisos a más largo plazo. CoreWeave declinó hacer comentarios y Lambda no respondió a una nuestra solicitud de réplica.

Resemble recurrió a FluidStack, un pequeño proveedor que acepta reservas de GPU de una semana o un mes, y recientemente se incorporó a San Francisco Compute Group, un consorcio de empresas emergentes que se comprometen conjuntamente a comprar y repartirse capacidad de GPU. “El ecosistema de startups está intentando reunirse y tratar de averiguar ‘¿cómo luchamos, cómo peleamos por la capacidad de procesamiento?’ De lo contrario, sería un juego realmente injusto. Los precios son demasiado altos”, apunta Ahmed.

Todos los lunes por la mañana recibe un rayo de esperanza sobre la escasez de GPU, cuenta. Un representante de ventas de Lambda, el proveedor de servicios en la nube, le escribió para preguntarle si Resemble quería reservar alguno de los chips más recientes de Nvidia, los H100. Que haya disponibilidad es emocionante, asegura Ahmed, pero esas unidades solo han estado disponibles desde marzo y es cuestión de tiempo antes de que las empresas que experimentan con ellas perfeccionen el código necesario para aprovechar al máximo su potencial. Nvidia sacará su último y mejor producto, el GH200 de segunda generación, el año que viene. Entonces, el ciclo de escasez volverá a comenzar.

Fuente: Wired